2023. 9. 12. 16:34ㆍArtificialIntelligence/2023GoogleMLBootcamp

Regularization

높은 차원의 W에 비해, b는 매우 낮은 차원(실수)

bias는 regularization 하지 않는다.

@Logistic regression

@Neural Network

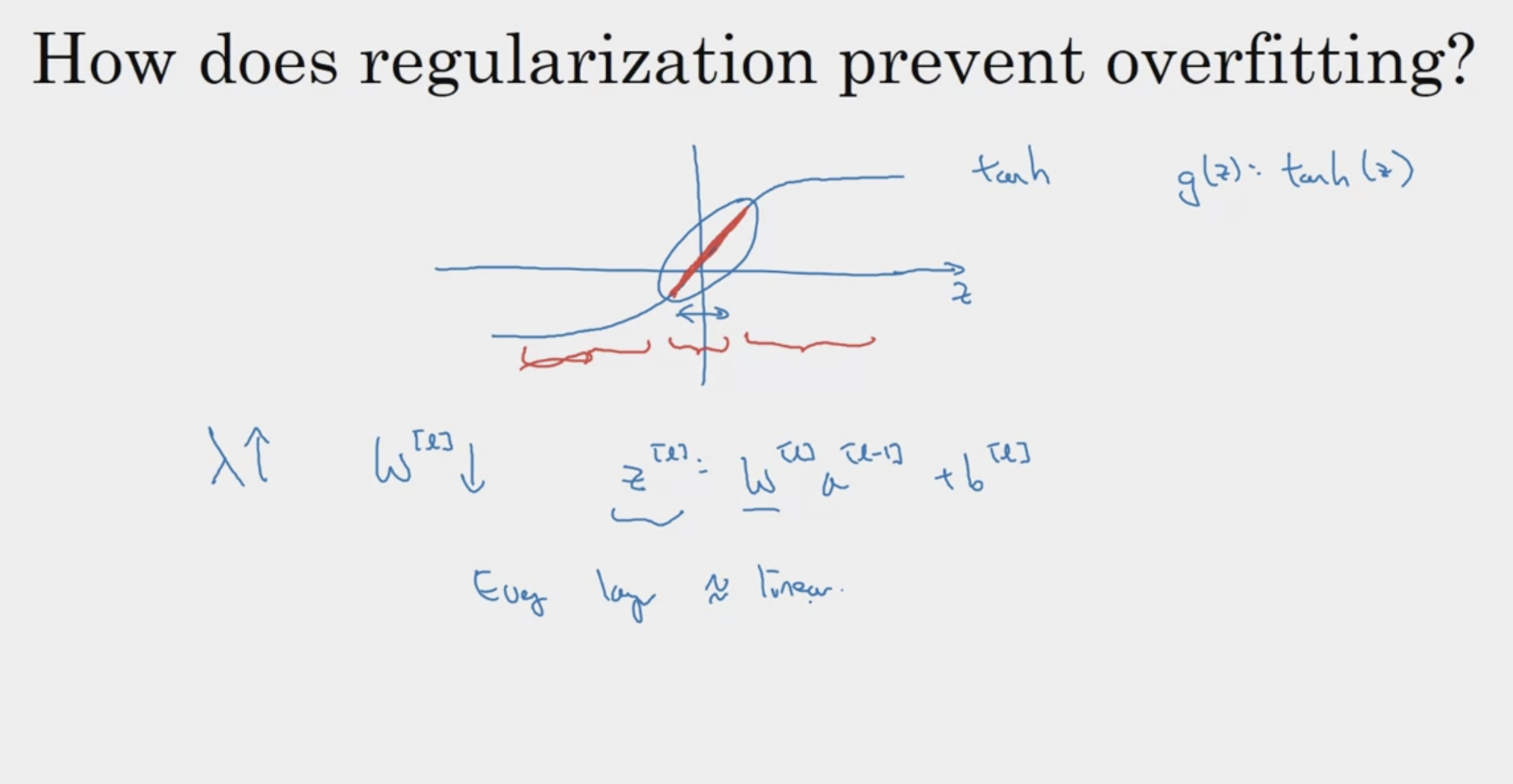

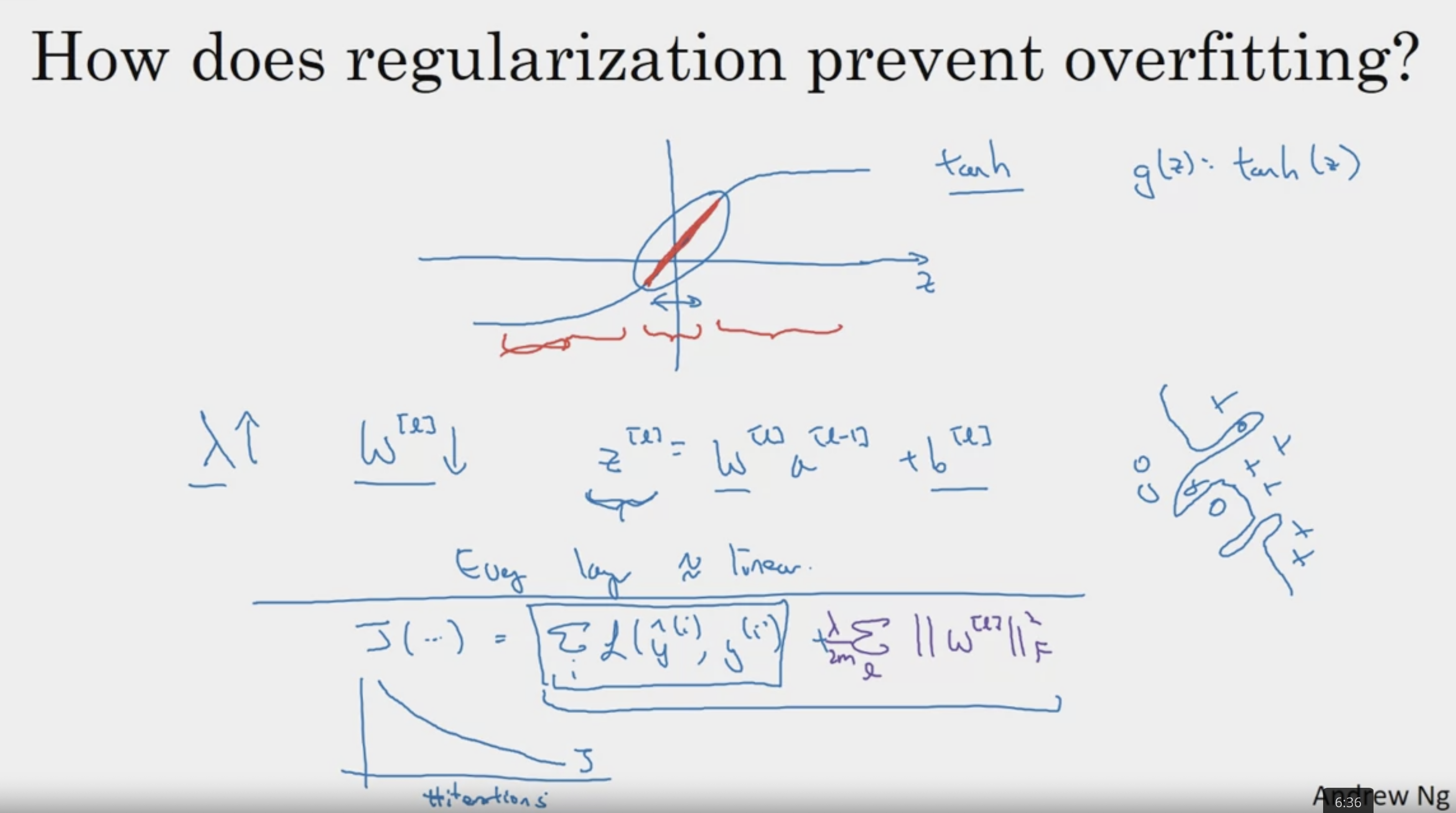

Why Regularization Reduces Overfitting?

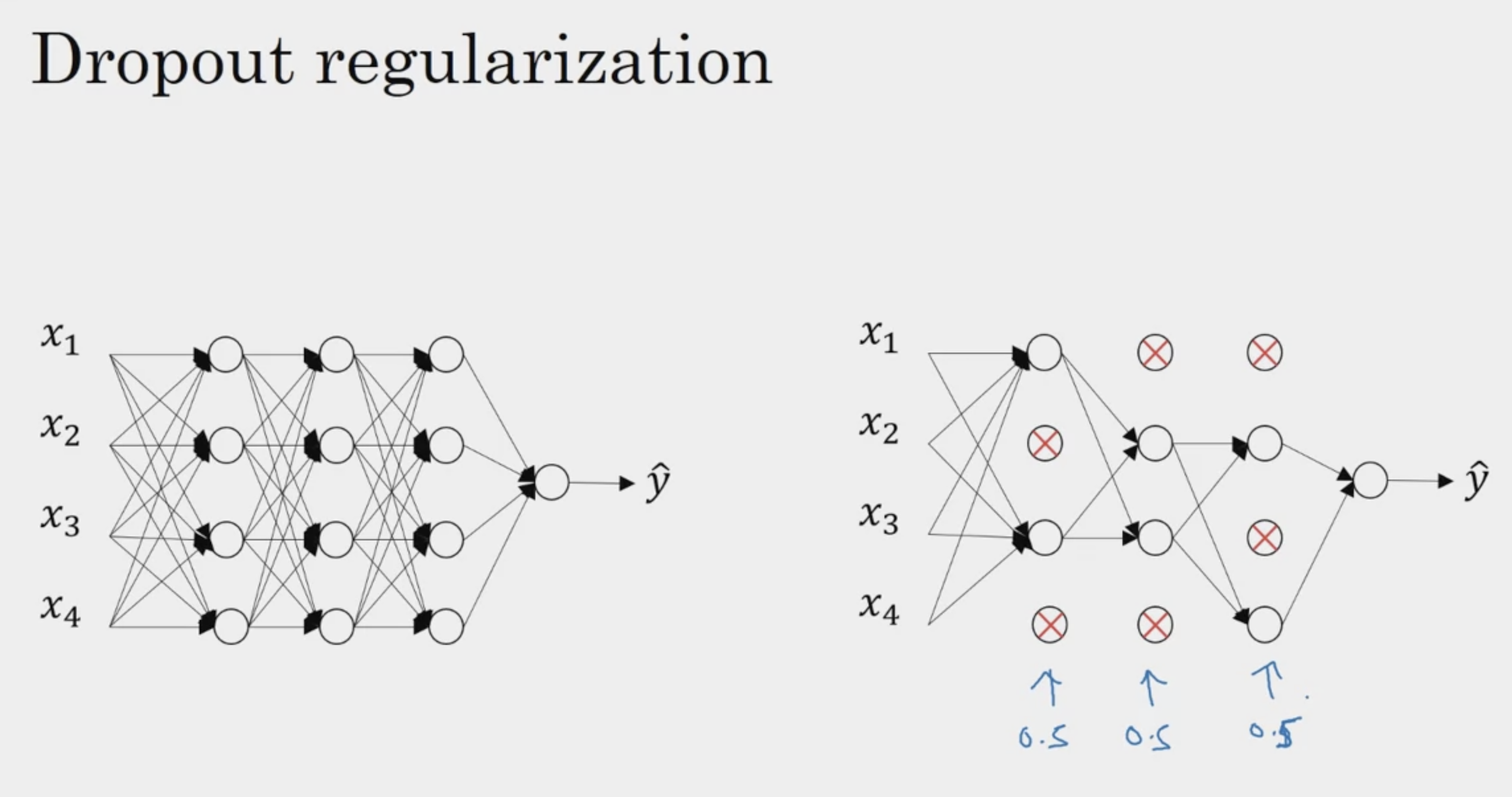

Dropout Regularization

더 작은 규모의 network로 만드는 역할

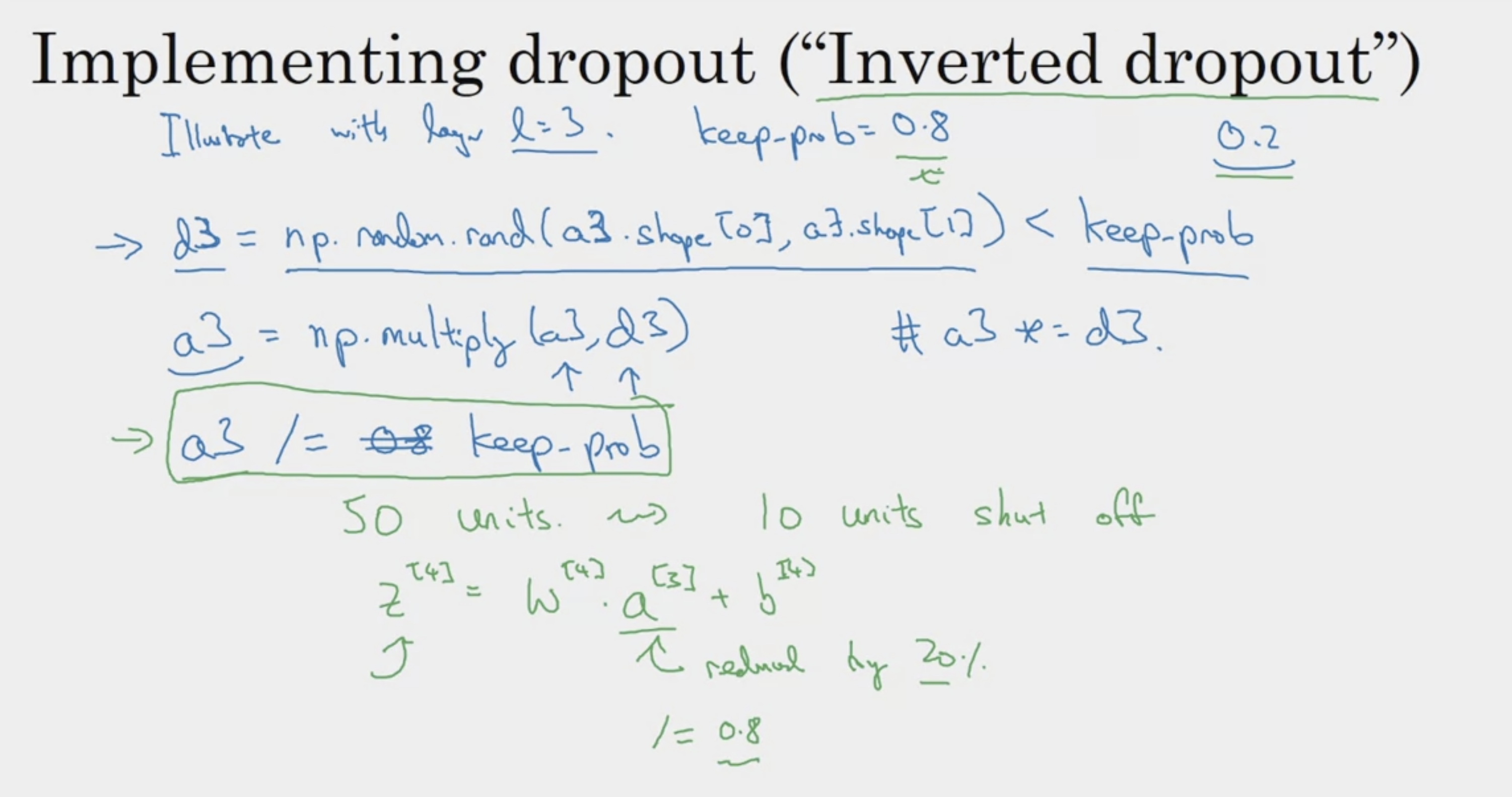

1보다 작은 값으로 나눈다 -> 키운다

activation 값의 차원을 키운다 (dropout으로 줄어들었기 때문에)

keep prob - 보존하려는 노드의 비율

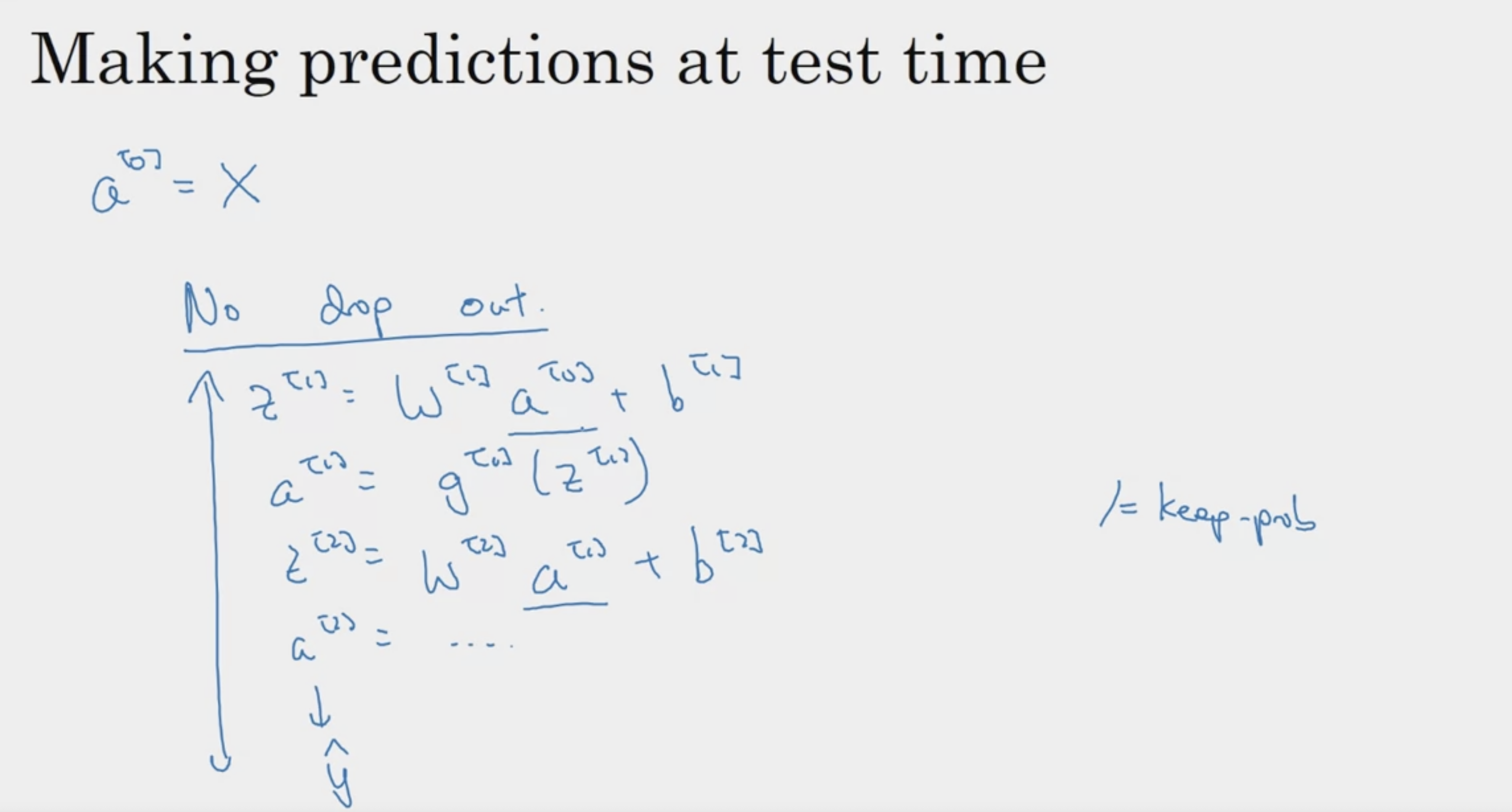

test time에서는 training time과 달리, 비율을 조정할 필요 X

In general, the number of neurons in the previous layer gives us the number of columns of the weight matrix,

and the number of neurons in the current layer gives us the number of rows in the weight matrix.

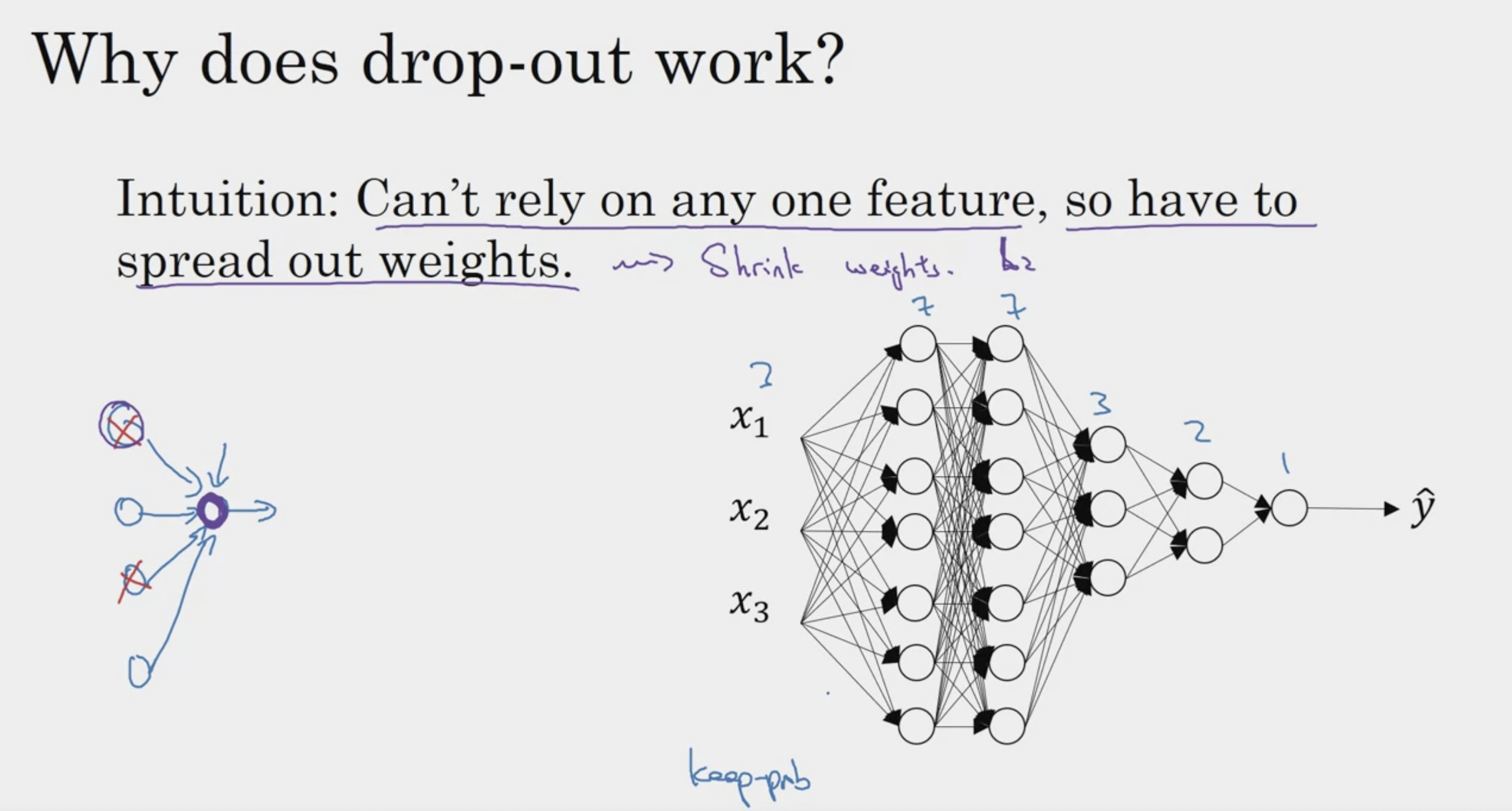

Understanding Dropout

layer의 node 수, 특성에 따라 dropout을 적용하는 keep-prob을 조정할 수 있다

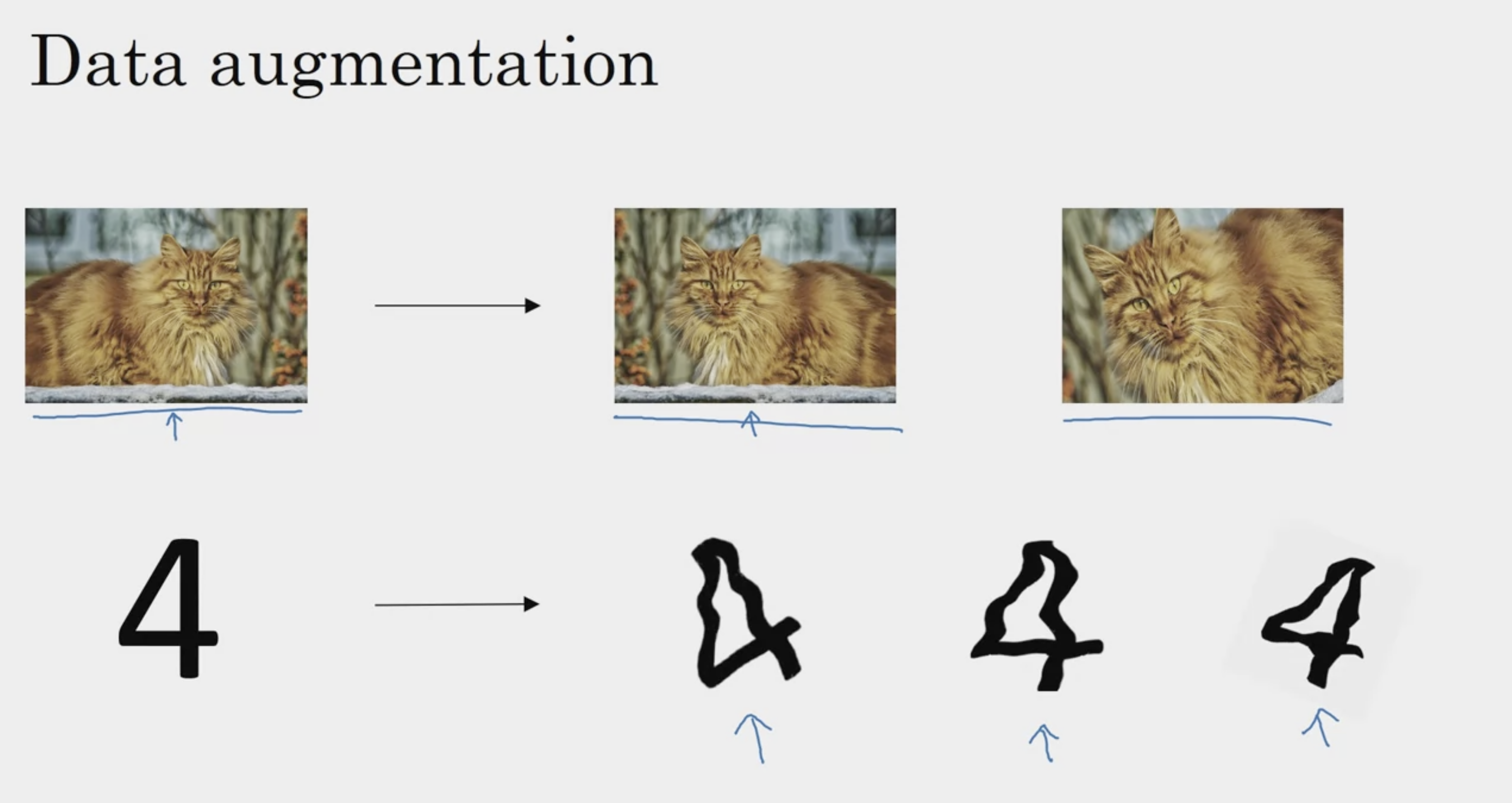

CV 분야에서 많이 사용되는 overfitting 방지 regularization

Other Regularization Methods

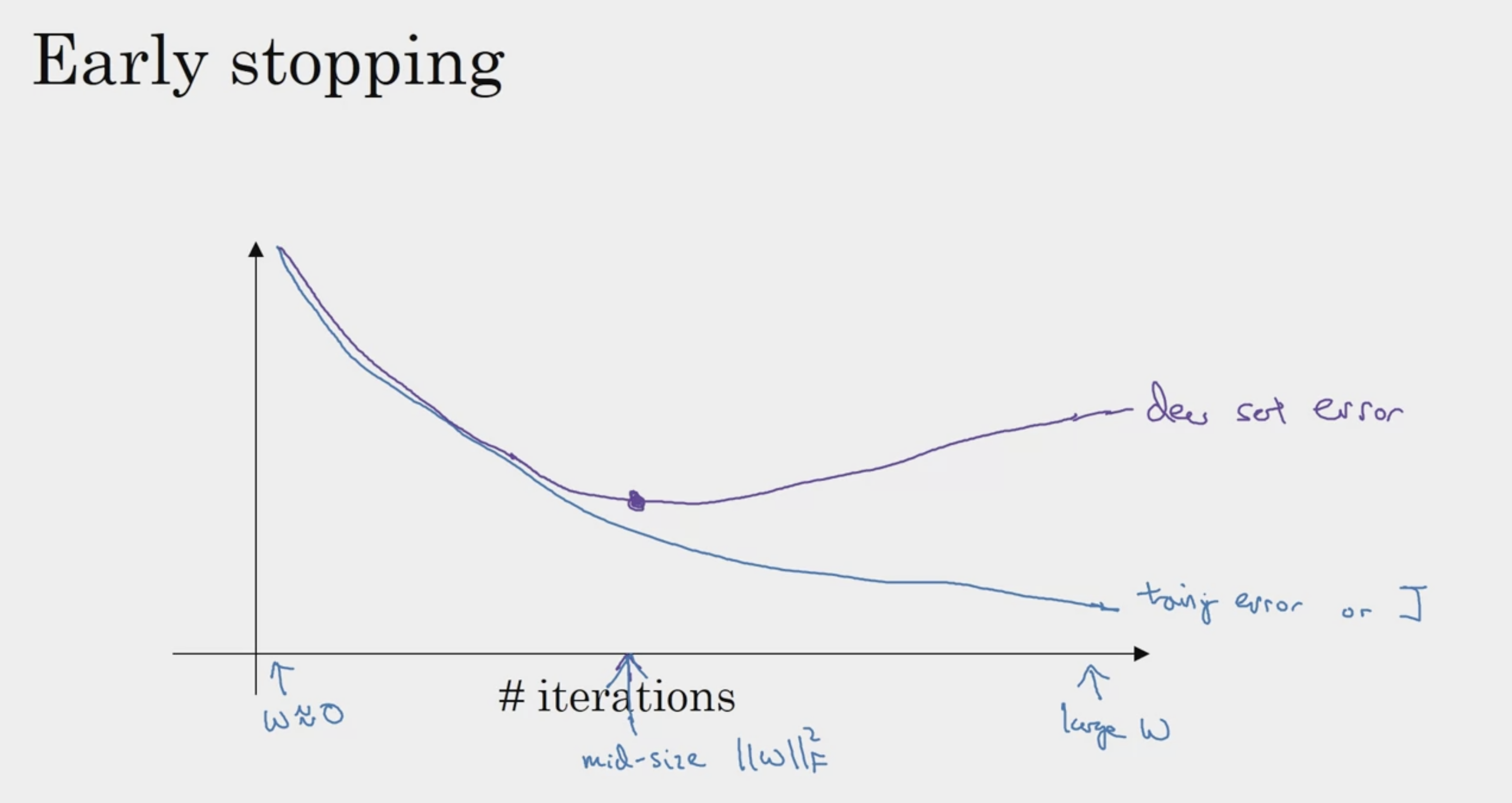

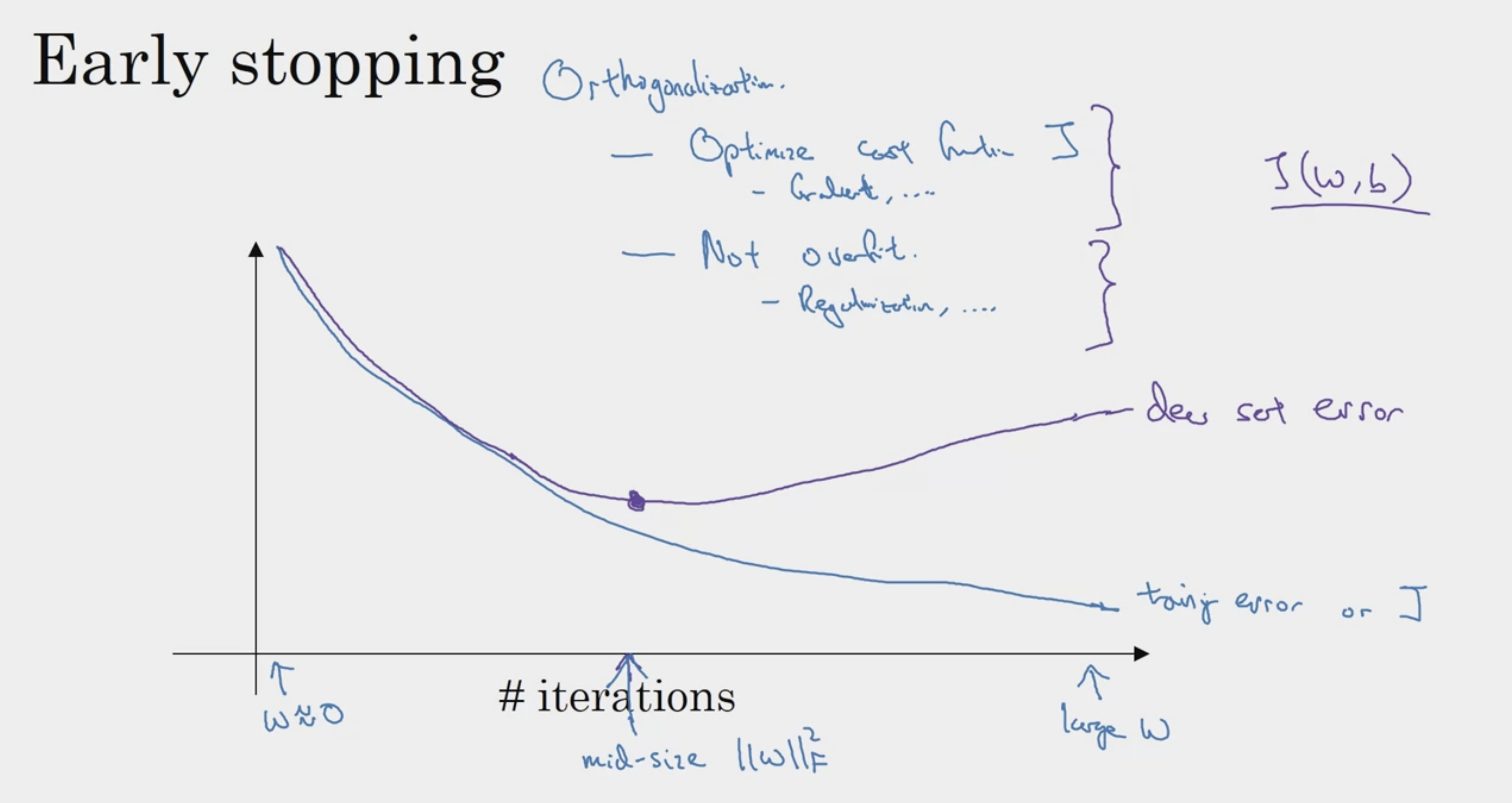

- validation(develop) error가 높아지기 전에 조기 멈춤 알고리즘

cost를 낮추는 목적 + 규제 (오버피팅 방지)

'ArtificialIntelligence > 2023GoogleMLBootcamp' 카테고리의 다른 글

| [GoogleML] Optimization Algorithms (0) | 2023.09.20 |

|---|---|

| [GoogleML] Optimization Problem (0) | 2023.09.13 |

| [GoogleML] Setting up Machine Learning (0) | 2023.09.12 |

| [GoogleML] Neural Networks and Deep Learning 수료 (0) | 2023.09.12 |

| [GoogleML] Deep Neural Network (0) | 2023.09.11 |